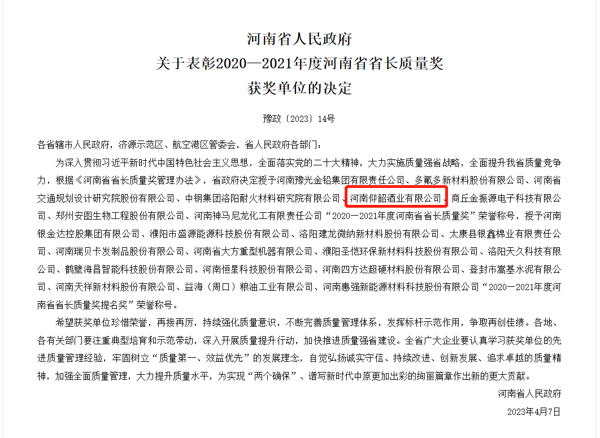

深度学习问题(Deep Learning Problems)是指在深度学习模型的开发和应用过程中可能遇到的挑战或困难。下面我将解释一些常见的深度学习问题,并提供简单易懂的解释。

过拟合(Overfitting):当训练的深度学习模型在训练数据上表现出色,但在新数据上表现不佳时,就可能出现过拟合问题。这意味着模型过于关注训练数据的细节,导致对新数据的泛化能力较差。为了解决过拟合问题,可以采取一些方法,如增加更多的训练数据、使用正则化技术(如L1或L2正则化)、引入dropout等。

欠拟合(Underfitting):与过拟合相反,欠拟合指的是模型无法在训练数据和新数据上都达到很好的性能。这通常是由于模型的复杂度不足或训练数据量不足引起的。为了解决欠拟合问题,可以尝试增加模型的复杂度、调整超参数、提供更多的训练数据等。

(相关资料图)

(相关资料图)

梯度消失和梯度爆炸(Vanishing and Exploding Gradients):在深度神经网络中,梯度的传播可能会遇到梯度消失或梯度爆炸的问题。梯度消失指的是在反向传播过程中,梯度逐渐变小并趋近于零,导致网络无法学习到有效的权重更新。梯度爆炸则是梯度变得非常大,导致权重更新过大而不稳定。为了应对这些问题,可以使用合适的激活函数、权重初始化方法(如Xavier初始化)、批量归一化等。

数据不平衡(Imbalanced Data):在某些分类问题中,训练数据中不同类别的样本数量差异很大,这会导致模型对多数类别进行较好的预测,而对少数类别进行较差的预测。解决数据不平衡问题的方法包括过采样、欠采样、生成合成样本(如SMOTE算法)以及使用适当的评估指标(如精确度、召回率、F1分数)。

超参数调优(Hyperparameter Tuning):深度学习模型中存在很多需要手动设置的超参数,如学习率、批量大小、隐藏层的神经元数量等。选择合适的超参数可以显著影响模型的性能。为了调优超参数,可以使用网格搜索、随机搜索、贝叶斯优化等技术,同时结合交叉验证来评估不同超参数组合的性能。

深度学习问题是指在深度学习模型的开发和训练过程中遇到的挑战或难题。这些问题可能涉及数据预处理、模型选择、超参数调整、过拟合或欠拟合等方面。以下是解决深度学习问题的一般步骤和一些有用的资源:

数据预处理:

确保数据集的质量和完整性,处理缺失值、异常值和噪声。

进行特征工程,提取与问题相关的有用特征。

模型选择:

根据问题的性质和数据集的特点选择合适的深度学习模型,例如卷积神经网络(CNN)、循环神经网络(RNN)或变换器(Transformer)等。

参考相关文献、教程和经验分享,了解不同模型的优劣势,以及它们在类似问题上的应用。

超参数调整:

调整模型的超参数,例如学习率、批量大小、隐藏层节点数等。

可以使用网格搜索、随机搜索或优化算法(如贝叶斯优化)来找到最佳的超参数组合。

过拟合和欠拟合:

如果模型在训练集上表现良好但在测试集上表现较差,可能出现过拟合问题。可以尝试使用正则化技术(如L1或L2正则化)或减少模型复杂度来解决。

如果模型在训练和测试集上表现都不佳,可能存在欠拟合问题。可以尝试增加模型的容量、改进特征工程或增加训练数据量。

有用的资源:

在线课程和教材:例如Coursera上的吴恩达的《深度学习专项课程》、斯坦福大学的CS231n课程等。

开源深度学习框架的文档和示例代码:例如TensorFlow、PyTorch等。

学术论文和研究预印本:可以通过arXiv等平台获取最新的深度学习研究成果。

关键词: